Chạy AI tại nhà không còn là giấc mơ với card đồ họa RTX 16GB

-

07/08/2025

- GAME ONLINE PC

Hôm qua, ngày 6 tháng 8 năm 2025, Nvidia đã công bố một thỏa thuận hợp tác quan trọng với OpenAI, cho phép các mô hình ngôn ngữ lớn (LLM) mạnh mẽ như gpt-oss-20b và gpt-oss-120b có thể chạy trực tiếp trên phần cứng của người dùng. Sự kết hợp này mở ra khả năng xử lý các tác vụ AI tiên tiến như suy luận phức tạp, hỗ trợ lập trình, tìm kiếm thông minh và phân tích tài liệu ngay trên máy tính cá nhân.

-

PUBG Mobile công bố những thay đổi lớn cho giải đấu PMGC 2025

-

Game Kaiju no 8 ấn định ngày phát hành vào cuối tháng 8

Đối với những người dùng sở hữu card đồ họa Nvidia GeForce RTX hoặc RTX Pro, đây là một tin tức đột phá. Giờ đây, họ có thể tiếp cận các mô hình AI cao cấp mà không cần trả phí đăng ký và không yêu cầu kết nối Internet.

Sự hợp tác này cho phép các nhà phát triển và người dùng đam mê công nghệ vận hành AI tạo sinh cục bộ để đạt được hiệu suất nhanh hơn, bảo mật hơn và không phụ thuộc vào đám mây. Đây là một lợi thế lớn cho những ai làm việc trong môi trường ngoại tuyến hoặc muốn toàn quyền kiểm soát các mô hình AI của mình

- Đối với người dùng gia đình: Mô hình gpt-oss-20b là lựa chọn lý tưởng. Tuy nhiên, tương tự như chơi game cấu hình cao, hệ thống cần có GPU với ít nhất 16GB VRAM. Nvidia khuyến nghị sử dụng GeForce RTX 4080 trở lên. Trên các hệ thống trang bị GeForce RTX 5090, thông lượng xử lý cục bộ có thể đạt khoảng 256 token mỗi giây.

- Đối với doanh nghiệp và máy chủ: Mô hình gpt-oss-120b yêu cầu GPU có ít nhất 80GB VRAM, do đó các GPU máy chủ Nvidia Blackwell là thiết bị cần thiết. Trên các nền tảng như GB200 NVL72, chúng có thể xử lý tới 1,5 triệu token mỗi giây, cho phép phục vụ hàng chục nghìn người dùng đồng thời.

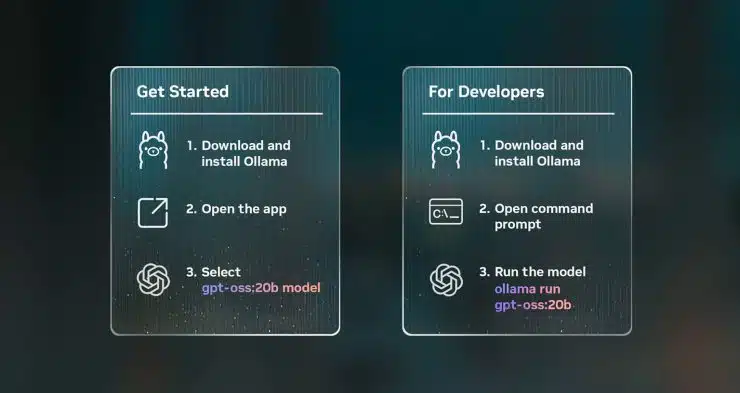

Để khai thác sức mạnh của các mô hình AI này, người dùng và nhà phát triển có thể lựa chọn giữa nhiều phương thức triển khai khác nhau, phù hợp với từng cấp độ kỹ năng. Phương pháp đơn giản nhất là sử dụng các mẫu có sẵn (Templates), cho phép người dùng phổ thông chỉ cần chọn một mẫu và bắt đầu trò chuyện ngay lập tức mà không cần cài đặt phức tạp, đồng thời hỗ trợ cả tệp PDF, câu lệnh đa phương thức và tùy chỉnh ngữ cảnh.

Trong khi đó, các nhà phát triển có thể tận dụng công cụ Microsoft AI Foundry Local để tích hợp mô hình thông qua dòng lệnh hoặc SDK, được xây dựng trên nền tảng ONNX Runtime và tối ưu hóa bằng CUDA cùng TensorRT để khai thác tối đa hiệu năng trên GPU RTX. Cuối cùng, dành cho người dùng cao cấp, Nvidia cũng đang làm việc với cộng đồng mã nguồn mở thông qua llama.cpp để cung cấp các tối ưu hóa chuyên sâu như Flash Attention, CUDA Graphs và hỗ trợ định dạng MBFP4 mới.

- Nhà vô địch đầu tiên của 2XKO lộ diện - 03/02/2026

- DRX LowHigh đăng quang ngôi vô địch Tekken World Tour 2025 Finals - 03/02/2026

- Neverness to Everness tung trailer gameplay 12 phút mãn nhãn - 03/02/2026

Chia sẻ:

Nhận xét

Hãy vui vẻ trò chuyện cùng nhau, đừng toxic. Báo cáo hành vi xấu tại. Liên hệ